Sujet : « Apprentissage De Trajectoires Robotiques Basé Sur Les Interactions Collaboratives Homme-Robot Dans Un Environnement De Réalité Augmentée »

Mots clés :Apprentissage de trajectoires, interaction homme-robot, capture de mouvements, télé opération, réalité augmentée, réalité virtuelle.

Direction des travaux

- Directeur de thèse : Samir OTMANE (PR IUT Evry Université Paris Saclay, IBISC équipe IRA2) – samirDOTotmaneATuniv-evryDOTfr

- Co-encadrant : Laredj BENCHIKH (MCF Univ. Evry Université Paris Saclay, IBISC équipe SIAM) – laredjDOTbenchikhATuniv-evryDOTfr

Ecole doctorale :

Sciences et Technologies de l’Information et de la communication (STIC) Université Paris-Saclay

Profil et compétences recherchées

Robotique, informatique

Résumé

Cette thèse se place dans la continuité de nos travaux de recherche sur la conception et l’élaboration de nouveaux outils d’aide à la planification et à l’apprentissage de trajectoires robotiques. Son but sera de mettre au point de nouveaux algorithmes permettant de prendre en compte des interactions collaboratives entre un humain et un robot dans un environnement de réalité augmenté. Ces algorithmes devront prendre en compte les capacités de l’interaction naturelle de l’humain dans son environnement réel et la capacité du robot à la reproduire dans son environnement industriel. Cette interaction intelligente homme-robot devra permettre une génération de trajectoires robotique et ce en temps réel.

Au cours de cette thèse, le doctorant devra dans un premier temps identifier un moyen de concilier la trajectoire souhaitée par l’humain au travers de sa gestuelle et la capacité du robot à réaliser cette trajectoire. Cette négociation intelligente sera traitée ensuite d’une manière transparente par rapport à l’utilisateur au travers d’un algorithme qui optimisera la trajectoire devant être exécutée par le robot en temps réel en fonction d’une trajectoire souhaitée par l’opérateur humain.

Contexte

L’outil robotique est de plus en plus indispensable dans l’industrie et en particulier dans les processus de production en général. Cependant, les temps de mise en œuvre des installations et de mise en service des robots sont de plus en plus courts. Par conséquent, l’industrie se dote d’outils lui permettant de pré établir les trajectoires de tous ses robots dans tous les secteurs de production (automobile, injection plastique, traitement de surface, agro-alimentaire, … etc.) et ce en utilisant des moyens de conception mécatronique et de simulation sur plateformes virtuelles.

L’industrie en générale et la fabrication automobile en particulier perdent aujourd’hui beaucoup de temps entre le moment où le modèle du véhicule est conçu et le moment où ce dernier est mis en fabrication en série sur les lignes de fabrication de leurs usines. Cette fabrication est globalement assurée par des moyens automatisés et plus souvent robotisés. Un délai est donc nécessaire pour la mise au point des automatismes et des tâches des robots relatives à un nouveau modèle de véhicule. Actuellement il n’existe essentiellement que 2 moyens pour réaliser l’apprentissage d’une trajectoire sur un robot :

- Soit par un apprentissage manuel par un opérateur, ce que l’on qualifie de ‘tout réel’.

- Soit par un logiciel de CAO (Conception Assistée par Ordinateur) robotique, ce que l’on qualifie de ‘tout virtuel’.

Les techniques actuelles ont leurs avantages mais aussi leurs inconvénients et leurs limites.

Apprentissage manuel de trajectoires :

Ce mode d’apprentissage a pour avantage de se faire directement sur le robot (réel) avec des essais de réglage et d’optimisation jusqu’à obtention de la trajectoire désirée. Néanmoins, son inconvénient majeur est de nécessiter des retouches continuelles durant la vie de la pièce afin de pouvoir atteindre l’optimum et d’immobiliser lors de la programmation de la trajectoire et à chaque retouche l’outil de production (qui est le robot). De plus, cette technique nécessite la présence de la pièce ou de son prototype réel pour pouvoir effectuer l’apprentissage de la trajectoire (figure 1).

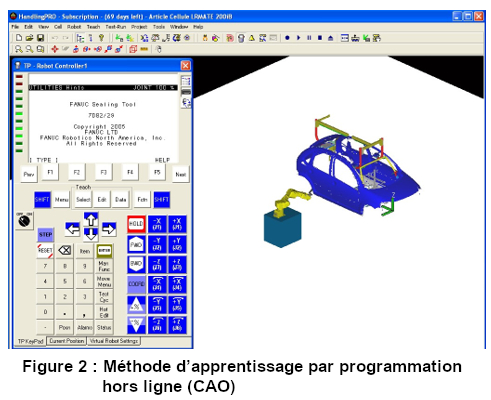

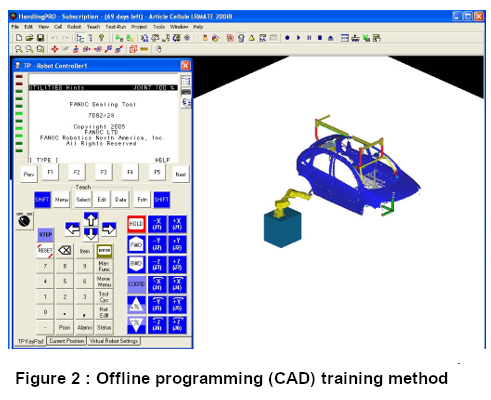

CAO robotique :

Ce mode de programmation de trajectoire a pour avantage d’être Hors-Ligne et se fait totalement dans un milieu virtuel (figure 2) et ne nécessite donc pas l’immobilisation de l’outil de production (le robot). Cependant, cela engendre des écarts importants par rapport au réel. Le robot virtuel (issu d’une librairie pré définie par un modèle mathématique) est toujours un robot ‘parfait’ ce qui engendre des décalages importants et la correction de tous les points de la trajectoire après son transfert sur le robot réel. Ces écarts sont dus au fait que le robot virtuel ne soit pas une ‘copie’ parfaite du robot réel comportant ses propres jeux mécaniques et dispersions dues à la fabrication ou tout simplement à une usure naturelle de ses organes mécaniques. L’autre inconvénient majeur de cette méthode est que les mouvements et comportement dynamique de l’accastillage embarqué sur le robot (câbles, tuyaux, housses, … etc.) ne peuvent être simulés en CAO (ils sont obligatoirement fixes) ce qui peut engendrer des interférences et des collisions lors du transfert de la trajectoire sur le robot réel (malgré d’éventuelles retouches). De plus, les temps de cycle robot calculés par la CAO sont approximatifs car ils sont liés à la fréquence d’échantillonnage et de calcul du processeur de l’outil CAO qui n’est pas la même que celle du processeur du robot. Autrement dit, les temps de cycle CAO et ceux du robot ne sont pas forcément identiques.

Nos travaux ces dernières années ont permis de proposer de nouvelles méthodes permettant d’assister l’opérateur humain pour la génération de trajectoires robotiques en utilisant des techniques de la réalité virtuelle/augmentée et de capture de mouvements de l’utilisateur. Nos travaux ont donc consisté à développer deux nouvelles méthodes :

- Apprentissage de trajectoires robotiques assisté par la réalité augmentée :

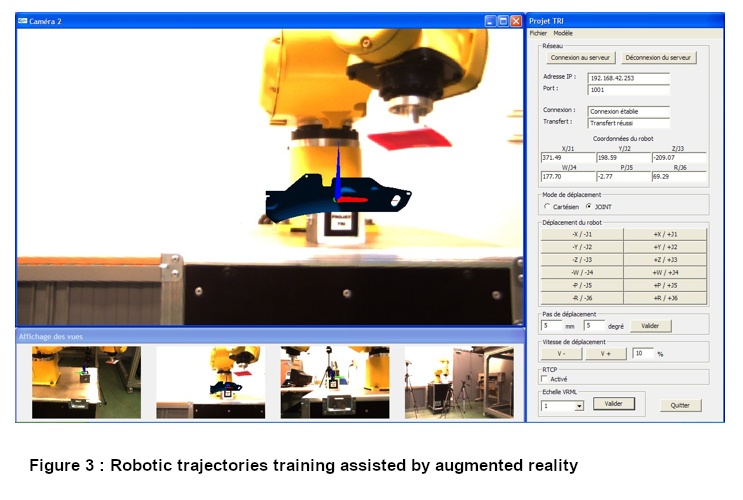

Cette méthode d’apprentissage de trajectoires robotiques permet de mêler étroitement la modélisation géométrique, cinématique et dynamique d’une plateforme robotisée à son image réelle [1]. L’originalité de ce procédé est de faire effectuer un apprentissage de la trajectoire du robot (qui est réel) par l’assistance d’un système de réalité augmentée. Le formalisme de guides virtuelles est utilisé pour assister l’opérateur dans sa tâche de manipulation dans un environnement de réalité augmentée [2][3]. Une interface a été développée permettant la planification de trajectoires en faisant interagir le robot réel avec le modèle 3D virtuel de la maquette numérique de la pièce (figure 3). Dans cette méthode, l’utilisateur qui interagit avec un clavier/souris et l’environnement augmenté est affiché sur un simple écran d’ordinateur. L’apprentissage de trajectoires sur le robot réel se fait hors ligne.

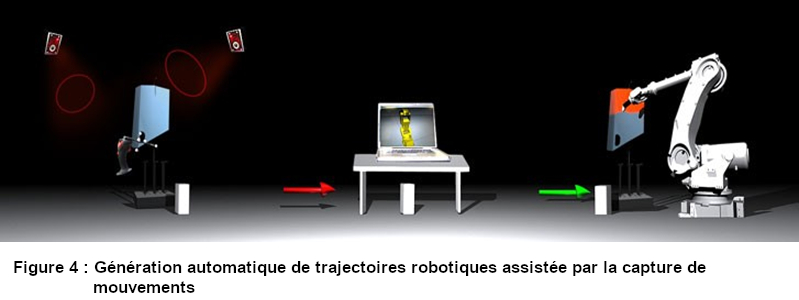

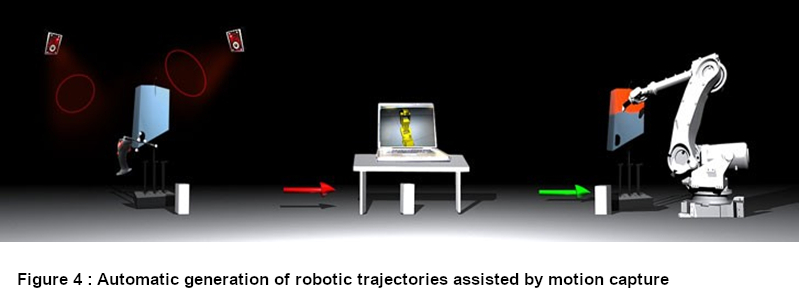

2) Génération automatique de trajectoires robotiques assistée par la capture de mouvements :

Cette méthode d’apprentissage de trajectoire est basée sur la capture de mouvements de la main de l’opérateur sans avoir à utiliser des robots ou un opérateur roboticien expérimenté [4]. L’une des revendications fortes de ce procédé est de pouvoir faire exécuter au robot des trajectoires issues de la capture de mouvements de la main d’un opérateur expert et qui par nature ne peuvent pas être reproduites par la programmation (figure 4). La trajectoire ainsi validée sera exportée sur le site de production afin de vérifier sa conformité par rapport aux spécifications (vitesse et précision) liées aux métiers tels que la peinture, la soudure, la manutention, etc. Dans cette méthode, l’utilisateur interagi en 3D via un Flystick (Joystick porté par la main dont les positions/orientations sont détectées grâce un système de tracking infrarouge). L’apprentissage de trajectoires sur le robot réel se fait également hors ligne.

Dans cette thèse, nous souhaitons étendre nos travaux vers un apprentissage collaboratif de trajectoires robotiques en réalité augmentée en impliquant l’humain et le robot simultanément (en temps réel) dans le processus de planification et d’exécution des trajectoires par un robot réel.

Pour réaliser cet apprentissage collaboratif, des verrous d’ordre scientifique et technologique doivent être levés et qui nécessitent de prendre en compte plusieurs facteurs impliquant 1) l’humain dans son environnement d’interaction/visualisation et 2) le robot réel dans son environnement industriel d’exécution. D’autres travaux récents appliqués au domaine de la santé notamment sur l’apprentissage de gestes techniques dans les simulateurs de réalité virtuelle [5][6], ou encore sur l’utilisation de systèmes de RA mobile comme Hololens pour la rééducation à la marche [6] pourraient être étendus et évalués dans un contexte d’usage en robotique industrielle concerné par ce projet de thèse.

Pour lever ces verrous des études et des expérimentations seront nécessaires pour développer une nouvelle méthode d’interaction collaborative homme-robot qui soit naturelle et intuitive (basée uniquement sur la gestuelle de l’opérateur humain (sans interfaces particulières de préférence). Pour atteindre cet objectif, plusieurs étapes sont nécessaires.

Étape 1 : État de l’art et étude de l’existant

- Une revue de la littérature sur les systèmes de réalité augmentée et d’interaction 3D utilisées dans le contexte de la robotique industrielle : systèmes de RA en vision directe ou indirecte, mobile ou fixe.

- Une revue de la littérature sur les méthodes de planification et d’apprentissage de trajectoires robotiques assistés par la réalité augmentée et par la capture de mouvements.

Cette étape nous permettra de choisir et/ou de proposer d’une part, le système de RA dont l’usage est approprié pour les applications industrielles mais aussi la méthode de planification et d’apprentissage de trajectoire robotiques pouvant être utilisée dans le cadre d’une interaction collaborative homme-robot en temps réel.

Étape 2 : Modélisation et conception de la nouvelle méthode d’apprentissage collaboratif :

- Modélisation de l’espace d’interaction 3D mixte (réel/virtuel) entre l’utilisateur et le robot réel.

- Proposition d’un algorithme d’intelligence artificielle permettant de générer en temps réel des trajectoires résultantes de ces interactions collaboratives homme-robot. Cet algorithme devra prendre en compte les capacités de l’interaction naturelle de l’humain dans son environnement réel et la capacité du robot à la reproduire dans son environnement industriel. Cette interaction intelligente homme-robot devra permettre une génération de trajectoires robotique et ce en temps réel.

- Conception d’une technique d’interaction 3D collaborative prenant en compte d’une part, les contraintes (géométriques cinématiques, dynamiques) du robot dans son environnement industriel qui permet de la précision, de la sécurité, de la rapidité et la reproductibilité, etc. Et d’autre part, les contraintes liées à l’opérateur humain dont la main est moins précise, moins rapide, moins sécurisée et avec une limitation des degrés de liberté, etc.

Cette étape nous permettra d’une part, de proposer un algorithme permettant de générer en temps réel des trajectoires résultantes de ces interactions collaboratives homme-robot (avec la prise en compte des différentes contraintes et facteurs : côté humain et côté robotique industrielle). D’autre part, de proposer une technique d’interaction 3D collaborative utilisant cet algorithme et doté d’une nouvelle interface d’interaction naturelle homme-robot permettant l’interaction et la visualisation en temps réel des résultats de cet apprentissage.

Étape 3 : Évaluation et expérimentation

- Évaluation de l’utilisabilité de cette technique d’interaction 3D collaborative par une expérience utilisateur dans un environnement virtuel.

- Évaluation dans un environnement de réalité augmentée de la pertinence de cette technique d’interaction 3D collaborative sur les performances de la tâche réelle d’apprentissage de trajectoires robotique, notamment sur la précision, le temps d’exécution et la sécurité.

- Comparaison de cette méthode avec d’autres méthodes de l’état de l’art, notamment avec celles développées dans nos travaux précédents.

Cette étape nous permettra de valider ou pas cette nouvelle méthode d’apprentissage collaboratif en temps réel, mêlant l’humain et le robot dans un environnement de réalité augmentée. L’ensemble des évaluations seront réalisées sur la plateforme de réalité virtuelle et augmentée EVR@ du laboratoire IBISC.

Étape 4 : Valorisation et diffusion des résultats :

- Étude de la possibilité de déposer un brevet si les résultats sont satisfaisants

- Publication des résultats dans des journaux de haut niveau et/ou conférences internationales aussi bien dans le domaine de la robotique (IEEE IROS, IEEE ICRA, etc.) que dans le domaine des réalité virtuelle/augmentée (IEEE ISMAR, IEEE VR, ACM VRST, ACM CHI, etc.).

- Démonstrations dans des salons académiques et industriels.

Participants et modalités pratiques

Cette thèse sera portée par l’équipe IRA2 du laboratoire IBISC (Université Paris-Saclay, Univ Evry). Les travaux seront mis en œuvre et évalués sur la plateforme de Réalité Virtuelle EVR@ de l’IBISC.

Le(la) candidat(e) retenu(e) sera inscrit(e) en thèse à l’École Doctorale Sciences et technologies de l’information et de la communication (STIC) de l’Université Paris-Saclay. La thèse sera placée sous la direction de Samir Otmane (IBISC/IRA2) et co-encadrée par Laredj Benchikh (IBISC/IRA2).

Des collaborations avec des industriels seront étudiées, notamment avec FANUC Robotics.

Candidature

Profil recherché :

- Diplômé(e) de Master 2 Recherche (ou équivalent) en Robotique, IHM et/ou RV.

- Si possible expérience (ex. stage) en Robotique / Réalité Virtuelle et/ou Augmentée

- Compétences en développement robotique, logiciel, programmation objet et 3D (type Unity/C#), bons bagages scientifiques.

- Intérêt pour la Robotique et la réalité virtuelle et augmentée.

- Bonne maitrise de la communication en français et en anglais (oral/écrit).

- Qualités recherchées : grande motivation, autonomie, rigueur, force de proposition, ouverture aux approches pluridisciplinaires.

La candidature devra être accompagnée d’un CV, d’une lettre de motivation et des relevés de notes M1 et M2. Les avis d’enseignants et du responsable de stage de recherche M2 seront appréciés.

Références :

[1] L. Benchikh « Method for Training a Robot or the Like, and Device for Implementing Said Method », Numéro de publication internationale WO 2009/090542 A2, 23-07-2009.

[2] S. Otmane, M. Mallem, A. Kheddar, F. Chavand, « Active virtual guides as an apparatus for augmented reality based telemanipulation system on the internet » Proceedings 33rd Annual Simulation Symposium, pp 185-191 (IEEE SS 2000)

[3] S. Otmane « Télétravail robotisé et réalité augmentée : Application à la télé-opération via internet » Thèse Université d’Évry Val d’Essonne, 2000.

[4] L. Benchikh, “System and Method for the Synchronous Reproduction of Movements of Hand or End Member by a Robot”, Brevet d’invention, Numéro de publication internationale WO 2011/039429 A1, 07-042011.

[5] A. Ricca, A. Chellali, S. Otmane, « The influence of hand visualization in tool-based motor-skills training, a longitudinal study » IEEE Virtual Reality and 3D User Interfaces, pp 103-112, IEEE VR 2021.

[6] A-L. Guinet, G. Bouyer, S. Otmane, E Desailly, « Validity of Hololens Augmented Reality Head Mounted Display for Measuring Gait Parameters in Healthy Adults and Children with Cerebral Palsy », MDPI Sensors 2021.

[7] A. Ricca, A. Chellli, S. Otmane, « Influence of hand visualization on tool-based motor skills training in an immersive VR simulator », IEEE International Symposium on Mixed and Augmented Reality, pp 260-268, (ISMAR 2020)

Thesis head

- Thesis supervisor : Samir OTMANE (PR IUT Evry Université Paris Saclay, IBISC équipe IRA2) – samirDOTotmaneATuniv-evryDOTfr

- Co-leader : Laredj BENCHIKH (MCF Univ. Evry Université Paris Saclay, IBISC équipe SIAM) – laredjDOTbenchikhATuniv-evryDOTfr

Ecole doctorale :

Sciences et Technologies de l’Information et de la communication (STIC) Université Paris-Saclay

Keywords: Trajectories training, human-robot interaction, motion capture, teleoperation, augmented reality, virtual reality.

Profile and skills required

Robotics, computer science

Abstract

This thesis is part of our research on the design and development of new path planning and trajectories training assistance tools. Its aim will be to develop new algorithms to take into account collaborative interactions between a human and a robot in an augmented reality environment. These algorithms should consider the capacities of the human natural interaction in their real environment and the capacity of the robot to perform it in its industrial environment. This intelligent human-robot interaction should allow the generation of robotic trajectories in real time.

In this thesis, the phd student should first identify a way to reconcile the trajectory desired by human through its gesture and the robot’s ability to achieve this trajectory. This intelligent negotiation should be processed transparently according to the user by an algorithm that will optimize the trajectory to be executed by the robot in real time and corresponding to the trajectory desired by the human operator.

Context

Robotics are becoming increasingly important in industry and in production processes. However, installation and commissioning of the robots are becoming increasingly shorter. Consequently, the industry is equipping itself with tools that allow it to pre-determine the trajectories of all its robots in all production sectors (automotive, plastic injection, surface treatment, food-industry, etc.) using mechatronic design and simulation on virtual platforms.

The industry in general and automotive manufacturing in particular lose a lot of time between the moment where the vehicle model is designed and the moment it is put into production on the manufacturing lines. This production is generally carried out by automated and more often robotized means. A delay is therefore necessary for the development of the automation and the robot tasks related to a new vehicle model.

Currently, there are essentially only 2 ways to carry out the training of robot trajectory: a. By manual training by an operator, which is called ‘all real’.

- Or by a CAD (Computer Aided Design) robotic software, which is called ‘all virtual’.

The current techniques have their advantages but also their disadvantages and their limits.

Manual training of trajectories: This training mode has the advantage of being done directly on the real robot with adjustment and optimization tests until the desired trajectory is obtained. Nevertheless, its major disadvantage is that it requires continuous rework during the life of the piece in order to reach the optimum and to immobilize the production tool (which is the robot) during the programming of the trajectory and at each rework. Moreover, this technique requires the presence of the piece or its real prototype to be able to carry out the training of the trajectory (figure 1).

Robotic CAD: The advantage of this trajectory programming mode is that it is off-line and is done entirely in a virtual environment (figure 2) and therefore does not require the production tool (the robot) to be immobilized. However, this leads to significant deviations from the real world. The virtual robot (issued from a library predefined by a mathematical model) is always a ‘perfect’ robot which generates important shifts and the correction of all the points of the trajectory after its transfer on the real robot. These deviations are due to the fact that the virtual robot is not a perfect ‘copy’ of the real robot with its own mechanical sets and dispersions due to the manufacturing process or simply to a natural deterioration of its mechanical components. The other major disadvantage of this method is that the movements and dynamic behaviour of the robot’s on-board hardware (cables, hoses, covers, etc.) cannot be simulated in CAD (they are necessarily fixed), which can lead to interference and collisions when transferring the trajectory to the real robot (despite possible rework). Moreover, the robot cycle times calculated by CAD are approximate because they are linked to the sampling and calculation frequency of the CAD tool processor, which is not the same as that of the robot processor. In other words, CAD cycle times and robot cycle times are not necessarily identical.

Our work in recent years has proposed new methods to assist the human operator in generating robotic trajectories using virtual/augmented reality and user motion capture techniques. Our work has therefore consisted in developing two new methods:

1) Robotic trajectories training assisted by augmented reality:

This robotic trajectory training method allows to closely mix the geometrical, kinematic and dynamic modelling of a robotic platform with its real image [1]. The originality of this method is to perform a training of the real robot trajectory by the assistance of an augmented reality system. The virtual guide formalism is used to assist the operator in his manipulation task in an augmented reality environment [2][3]. An interface has been developed that allows the planning of trajectories by interacting the real robot with the virtual 3D model of the piece (figure 3). In this method, the user interacts with a keyboard/mouse and the augmented environment is displayed on a simple computer screen. The training of the trajectories on the real robot is done offline.

2) Automatic generation of robotic trajectories assisted by motion capture:

This method of trajectories training is based on the capture of operator’s hand movements without having to use robots or an experimented robotic operator [4]. One of the strong claims of this method is to make possible the execution (by the robot) of the trajectories resulting from the capture of the hand movements of an expert operator and which by nature cannot be reproduced by programming (figure 4). The validated trajectory will be exported to the production site in order to check its compliance with the specifications (speed and precision) related to the activity such as painting, welding, handling, etc. In this method, the user interacts in 3D via a Flystick (Joystick carried by the hand which positions/orientations are detected by an infrared tracking system). The training of the trajectories on the real robot is also done offline.

In this thesis, we wish to extend our work towards a collaborative training of the robotic trajectories in augmented reality by involving simultaneously the human and the robot (in real time) in the process of planning and execution of the trajectories by a real robot.

In order to achieve this collaborative training, scientific and technological issues need to be addressed and several factors need to be taken into account involving 1) the human in its interaction/visualization environment and 2) the real robot in its industrial execution environment. Other recent works applied to the health domain, in particular on the learning of technical gestures in virtual reality simulators [5][6], or on the use of mobile AR systems such as Hololens for walking rehabilitation [6] could be extended and evaluated in an industrial robotics context concerned by this thesis project.

In order to address these issues, studies and experimentation will be necessary to develop a new method of collaborative human-robot interaction that is natural and intuitive (based only on the human operator’s gestures, preferably without any particular interface). To reach this goal, several steps are necessary.

Step 1: State of the art and study of the current work

- A literature review on augmented reality and 3D interaction systems used in the context of industrial robotics: AR systems in direct or indirect vision, mobile or fixed platforms.

- A literature review on the methods of planning and training of the robotic trajectories assisted by augmented reality and by motion capture.

This first step will allow us to choose and/or propose, on the one hand, the AR system which the use is appropriate for industrial applications and, on the other hand, the method of planning and training of the robotic trajectory which can be used in the context of a real-time collaborative human-robot interaction.

Step 2: Modeling and design of the new collaborative training method:

- Modeling of the mixed 3D interaction space (real/virtual) between the user and the real robot.

- Proposition of an artificial intelligence algorithm allowing to generate (in real time) trajectories resulting from these human-robot collaborative interactions. This algorithm will have to take into account the natural interaction capabilities of the human in its real environment and the capacity of the robot to reproduce it in its industrial environment. This intelligent human-robot interaction must allow the generation of robotic trajectories in real time.

- Design of a collaborative 3D interaction technique taking into account, on the one hand, the constraints (geometrical, kinematic, dynamic) of the robot in its industrial environment which allows precision, safety, speed and reproducibility, etc. And on the other hand, the constraints related to the human operator whose hand is less precise, less fast, less secure and with a limitation of the degrees of freedom, etc.

This step will allow us, on the one hand, to propose an algorithm allowing to generate (in real time) trajectories resulting from these human-robot collaborative interactions (with the taking into account of the various constraints and factors: on the human side and on the industrial robotics side). On the other hand, to propose a collaborative 3D interaction technique using this algorithm and equipped with a new natural human-robot interface allowing the interaction and the visualization in real time of the results of this training.

Step 3: Evaluation and experimentation

- Evaluation of the usability of this collaborative 3D interaction technique through a user experience in a virtual environment.

- Evaluation in an augmented reality environment of the relevance of this collaborative 3D interaction technique on the performance of the real trajectories training of robotic task, especially on the accuracy, the execution time and the safety.

- Comparison of this method with other state of the art methods, especially with those developed in our previous works.

This step will allow us to validate or not this new real-time collaborative training method, mixing human and robot in an augmented reality environment. All the evaluations will be performed on the virtual and augmented reality platform EVR@ of the IBISC laboratory.

Step 4: Valorisation and dissemination of results:

- Study of the possibility of applying for a patent if the results are satisfactory

- Publication of the results in high level journals and/or international conferences in the field of robotics (IEEE IROS, IEEE ICRA, etc.) as well as in the field of virtual/augmented reality (IEEE ISMAR, IEEE VR, ACM VRST, ACM CHI, etc.).

- Demonstrations in academic and industrial exhibitions.

Participants and practical details

This thesis will be carried out by the IRA2 team of the IBISC laboratory (Université Paris-Saclay, Univ Evry). The work will be carried out and evaluated on the Virtual Reality platform EVR@ of IBISC laboratory. The selected candidate will be registered as a PhD student at the Doctoral School of Information and Communication Sciences and Technologies (STIC) of the Université Paris-Saclay. The thesis will be under the supervision of the professor Samir Otmane (IBISC/IRA2) and co-supervised by Laredj Benchikh (assistant professor, IBISC/IRA2).

Collaborations with industrial companies will be studied, in particular with FANUC Robotics.

Application

Desired profile:

- Master 2 Research (or equivalent) in Robotics, HMI and/or VR.

- If possible, experience (ex. internship) in Robotics, Virtual and/or Augmented Reality.

- Skills in robotics, software development, object and 3D programming (Unity/C# type), good scientific background.

- Interest in interaction design, rapid prototyping, testing, and evaluation with end users.

- Good communication skills in French and English (oral/written).

- Qualities needed: great motivation, autonomy, attention, ability to make proposals, openness to multidisciplinary approaches.

The application must be accompanied by a CV, a motivation letter and M1 and M2 marks. The comments of teachers and the M2 research supervisor will be appreciated.

References :

[1] L. Benchikh « Method for Training a Robot or the Like, and Device for Implementing Said Method », Numéro de publication internationale WO 2009/090542 A2, 23-07-2009.

[2] S. Otmane, M. Mallem, A. Kheddar, F. Chavand, « Active virtual guides as an apparatus for augmented reality based telemanipulation system on the internet » Proceedings 33rd Annual Simulation Symposium, pp 185-191 (IEEE SS 2000)

[3] S. Otmane « Télétravail robotisé et réalité augmentée : Application à la télé-opération via internet » Thèse Université d’Évry Val d’Essonne, 2000.

[4] L. Benchikh, “System and Method for the Synchronous Reproduction of Movements of Hand or End Member by a Robot”, Brevet d’invention, Numéro de publication internationale WO 2011/039429 A1, 07-042011.

[5] A. Ricca, A. Chellali, S. Otmane, « The influence of hand visualization in tool-based motor-skills training, a longitudinal study » IEEE Virtual Reality and 3D User Interfaces, pp 103-112, IEEE VR 2021.

[6] A-L. Guinet, G. Bouyer, S. Otmane, E Desailly, « Validity of Hololens Augmented Reality Head Mounted Display for Measuring Gait Parameters in Healthy Adults and Children with Cerebral Palsy », MDPI Sensors 2021.

[7] A. Ricca, A. Chellli, S. Otmane, « Influence of hand visualization on tool-based motor skills training in an immersive VR simulator », IEEE International Symposium on Mixed and Augmented Reality, pp 260-268, (ISMAR 2020)

- Date de l’appel : 30/04/2021

- Statut de l’appel : Non pourvu

- Contacts : Samir OTMANE (PR Univ. Évry, IBISC équipe IRA2), Laredj BENCHIKH (MCF Univ. Évry, IBISC équipe IRA2)

- Sujet de thèse (format PDF)

- Web équipe IRA2