Offre de thèse financée (English version below)

Titre : « Interactions collaboratives et multimodales pour la formation médicale en réalité virtuelle »

Mots clef : Réalité Virtuelle, Interactions multimodales, Interactions collaboratives, Compagnonnage, Formation médicale

Contexte

Cette thèse s’inscrit dans les domaines de l’interaction humain-machine et de la réalité virtuelle (RV) appliqués à la formation médicale. Elle vise à concevoir et évaluer des interactions multimodales et collaboratives permettant à un formateur d’enseigner des gestes techniques en médecine à un apprenant dans un environnement virtuel. Elle sera réalisée dans le cadre du projet Show-me (Virtual reality mentee-mentor multimodal collaboration for surgical skills training) financé par l’ANR en collaboration avec le LabForSIMS, le CHSF, le LISN et le LS2N.

Problématique

Les internes en médecine sont traditionnellement formés sur la base du modèle de compagnonnage en s’entrainant sur les patients au cours des stages hospitaliers encadrés par des experts. Cependant, pour des raisons éthiques et de sécurité des patients, comme conclut par le rapport de la Haute Autorité de Santé 2012 « jamais la première fois sur le patient », le développement de nouveaux paradigmes de formation médicale innovants basés sur la simulation devient un nécessité et une urgence. Pour assurer cette transition pédagogique, les simulateurs basés sur les technologies de la réalité virtuelle peuvent jouer un rôle important. Cependant, leur développement reste complexe et potentiellement coûteux. Il est donc nécessaire de concentrer leur conception et leur utilisation sur les besoins réels de formation des professionnels de santé.

L’objectif du projet ANR Show-Me est de concevoir de nouvelles techniques d’interaction multimodales et collaboratives et des interfaces utilisateurs innovantes permettant à un tuteur expert de partager ses compétences, de superviser et de guider un apprenant à travers un environnement de formation collaboratif et multimodal en réalité virtuelle pour un meilleur transfert des compétences médicales techniques. Cela permettra de garder le formateur dans la boucle et de profiter ainsi des avantages du modèle de compagnonnage mais dans un environnement plus sûr.

L’objectif de ce projet de thèse sera de concevoir des techniques d’interaction multimodales et collaboratives permettant de supporter la formation médicale par compagnonnage à travers la réalité virtuelle. Pour ce faire, il sera nécessaire de réaliser des études sur le terrain afin de mieux comprendre les interactions apprenant-formateur dans les situations de formations actuelles. Ces études permettront de définir un modèle d’interaction mentor-apprenant et ainsi guider la conception centrée utilisateur des techniques d’interactions collaboratives et multimodales. Des études expérimentales seront réalisées pour évaluer l’utilisabilité et l’efficacité des techniques conçues et pour extraire des lignes directrices pour la conception de simulateurs virtuels pour la formation par compagnonnage.

Compétences et qualités requises

Avoir un Master 2 ou équivalent en Interaction humain-machine, réalité virtuelle, et/ou ergonomie des interfaces, bonne maîtrise de la conception/programmation (Unity 3D/C#, C++), connaissance des interactions 3D, de la réalité virtuelle, de la méthodologie de conception centrée utilisateur, des tests utilisateurs, avoir un goût pour la recherche, le travail d’équipe et les échanges pluridisciplinaires.

Conditions de travail

La thèse se déroulera au sein de l’équipe IRA² du laboratoire IBISC. Une plateforme expérimentale (plateforme EVR@) et des EV pour la simulation chirurgicale sont mis à disposition. Le doctorant sera en interaction avec les autres doctorants et stagiaires de l’équipe. Il sera également convié à participer à certaines réunions avec les cliniciens et à faire des observations sur le terrain dans les hôpitaux et les centres de formation médicale partenaires.

Durée : 36 mois

Date de Début : Septembre ou Octobre 2021

Information de contact

Merci de faire parvenir une lettre de motivation, un CV, les relevés de notes du Master 2, et deux lettres de recommandations recherche à :

Amine CHELLALI – tél 01 69 47 75 33, courriel amineDOTchellaliATuniv-evryDOTfr

Laboratoire IBISC, équipe IRA2 – Université Paris Saclay (Campus Evry)

36 Rue du Pelvoux

91080 EVRY-COURCOURONNES

Fully funded PhD thesis

Title : « Multimodal collaborative interactions for medical training in virtual reality »

Keywords : Virtual Reality, Multimodal interactions, Collaborative interactions, Mentorship, Medical training

Context

This PhD thesis is in the fields of human machine interaction (HCI) and virtual reality (VR) applied to medical training. It aims to design new multimodal and collaborative interactions allowing a mentor to teach technical medical skills to a mentee in a shared virtual environment. This is part of the Show-me project (Virtual reality mentee-mentor multimodal collaboration for surgical skills training) funded by the National Research Agency (ANR) in collaboration with LabForSIMS, CHSF, LISN and LS2N.

Research problematic

Medical interns are traditionally trained through the mentorship model by practicing on real patients during hospital internships supervised by experts. However, due to clear ethical and patient safety issues, as concluded by the 2012 Haute Autorité de Santé report « never the first time on the patient », the development of new innovative medical training paradigms based on simulation becomes a necessity and an emergency. To support this transition, simulators based on virtual reality technologies can play an important role. However, their development remains complex and potentially expensive. It is therefore necessary to focus their design and use on the real training needs of healthcare professionals.

The ANR Show-Me project aims to design multimodal and collaborative interaction techniques and innovative user interfaces allowing an expert tutor to share his skills, supervise and guide a learner through a collaborative training environment and multimodal in virtual reality for a better transfer of technical medical skills. This permits to keep the mentor in the loop and thus to benefit from the advantages of the mentorship model but in a safer environment.

The aim of this thesis project will be to design multimodal and collaborative interaction techniques to support medical training through mentoring in Virtual Reality. For that purpose, it will be necessary to carry out field studies in order to better understand the learner-instructor interactions in current training situations. These studies will help the definition of a mentor– mentee interaction model and thus guide the user-centered design of collaborative and multimodal interaction techniques. Experimental studies will be performed to assess the usability and efficacy of the designed techniques and to extract guidelines for the design of virtual simulators for mentorship training.

Qualifications

Master 2 or equivalent or equivalent in HCI, VR or Ergonomics, good experience with HCI, UI design and programming (Unity 3D/C#C++), knowledge in 3D multimodal interactions, virtual reality, user-centered design, user studies, high interest in research, teamwork and multidisciplinary work.

Work conditions

The work will be carried out within the IRA² team at the IBISC Lab. An experimental platform (EVR@) and existing virtual environments for surgical simulation will be available. The PhD student will be in constant interaction with the team’s PhD students and interns. He/she will also be invited to participate in research meetings with the project partners and to conduct field studies in the partner hospitals and training centers.

Duration: 36 months

Start date: September or October 2021

Contact information

Please send your application letter, a CV, two research recommendation letters, and Master 2 transcripts to:

Amine CHELLALI Laboratoire IBISC EA 4526 – Equipe IRA2 01 69 47 75 33 Université Paris Saclay (Campus Evry)

amineDOTchellaliATuniv-evryDOTfr Bâtiment Pelvoux 2, IUP https://www.ibisc.univ-evry.fr 40, Rue du Pelvoux

Courcouronnes 91020 EVRY

References

- Chellali A, Mentis H, Miller A, Ahn W, Arikatla V, Sankaranarayanan G, Schwaitzberg S, Cao C (2016) Achieving Interface and Environment Fidelity in the Virtual Basic Laparoscopic Surgical Trainer. IJHCS 96: 22–37 HAL https://hal.archives-ouvertes.fr/hal-01344244/

- Chellali A, Dumas C, Milleville-Pennel I (2012) Haptic communication to support biopsy procedures learning in virtual environments. Presence: Teleoperators and Virtual Environments 21(4): 470–489 HAL https://hal.archives-ouvertes.fr/hal-00757319

- Mentis H, Chellali A, Schwaitzberg S (2014) Learning to see the body: supporting instructional practices in laparoscopic surgical procedures. Proceedings of the CHI Conference on Human Factors in Computing Systems, pp 2113–2122 HAL https://hal.archives-ouvertes.fr/IBISC/hal-00957806

- Mentis HM, Feng Y, Semsar A, Ponsky TA (2020) Remotely Shaping the View in Surgical Telementoring. Proceedings of the CHI Conference on Human Factors in Computing Systems, pp 1–14

- Le Chénéchal M, Duval T, Gouranton V, Royan J, Arnaldi B (2019) Help! I Need a Remote Guide in My Mixed Reality Collaborative Environment. Frontiers in Robotics and AI 6: 106

- Chengyuan, Edgar, Maria, et al. (2020) How About the Mentor? Effective Workspace Visualization in AR Telementoring. 2020 IEEE Conference on Virtual Reality and 3D User Interfaces (VR)

- Lee G, Kang H, Lee J, Han J (2020) A User Study on View-sharing Techniques for One-to-Many Mixed Reality Collaborations. 2020 IEEE Conference on Virtual Reality and 3D User Interfaces (VR)

- Moll J, Frid E (2017) Using eye-tracking to study the effect of haptic feedback on visual focus during collaborative object managing in a multimodal virtual interface. SweCog 2017, October 26–27, Uppsala, Sweden, pp 49–51

- Moll J, Pysander ELS, Eklundh KS, Hellström SO (2014) The effects of audio and haptic feedback on collaborative scanning and placing. Interacting with computers 26: 177–195

- Wang J, Chellali A, Cao CGL (2016) Haptic communication in collaborative virtual environments. Human factors 58: 496–508 HAL https://hal.archives-ouvertes.fr/hal-01223967

- Ricca, A. Chellali, A., Otmane, S. (2020) Influence of hand visualization on tool-based motor skills training in an immersive VR simulator. In the proceedings of IEEE International Symposium on Mixed and Augmented Reality (ISMAR), pp 339-347 HAL https://hal.archives-ouvertes.fr/hal-02921192

- Ricca A, Chellali A, Otmane S (2021) Comparing touch-based and head-tracking navigation techniques in a virtual reality biopsy simulator. Virtual Reality, 25, pages 191–208 HAL https://hal.archives-ouvertes.fr/hal-02861408

- Gamelin, G.,Chellali, A., Cheikh, S., Ricca, A., Dumas, C., Otmane, S. (2021) Point-cloud avatars to improve spatial communication in immersive collaborative virtual environments, Personal and Ubiquitous Computing, 25, 467–484 HAL https://hal.archives-ouvertes.fr/hal-02898350

- Ricca, A. Chellali, A., Otmane, S. (2021) The influence of hand visualization in tool-based motor-skills training, a longitudinal study. In the proceedings of IEEE Virtual Reality and 3D User Interfaces 2021 Conference (IEEE VR), 103-112 HAL https://hal.archives-ouvertes.fr/hal-03132374/

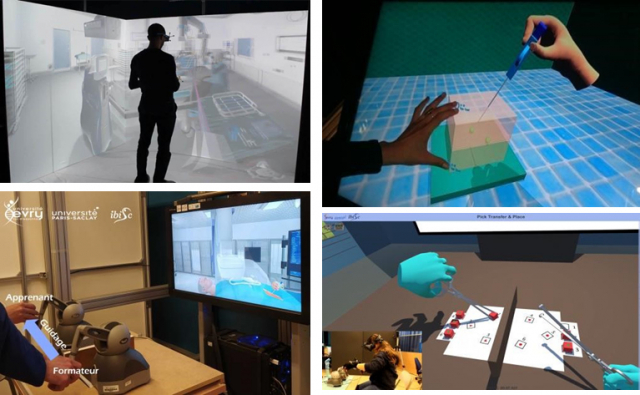

Figure 1 : Exemples des simulations et technologies présentes sur la plateforme EVR@ (CAVE, casques, systèmes de eye tracking, gants de données, bras à retour d’efforts, écrans tactiles…)

Examples of simulations and technologies (CAVE, HMDs, eye tracking devices, data gloves, haptic devices, touch screens …) used in our EVR@ platform

- Date de l’appel : 12/07/2021

- Statut de l’appel : Pourvu

- Contact : Amine CHELLALI (MCF Univ. Évry, IBISC équipe IRA2)

- Sujet de thèse (format PDF)

- Projet ANR SHOW-ME

- Web équipe IRA2